Como se proteger quando os seus dados sensíveis são usados contra você?

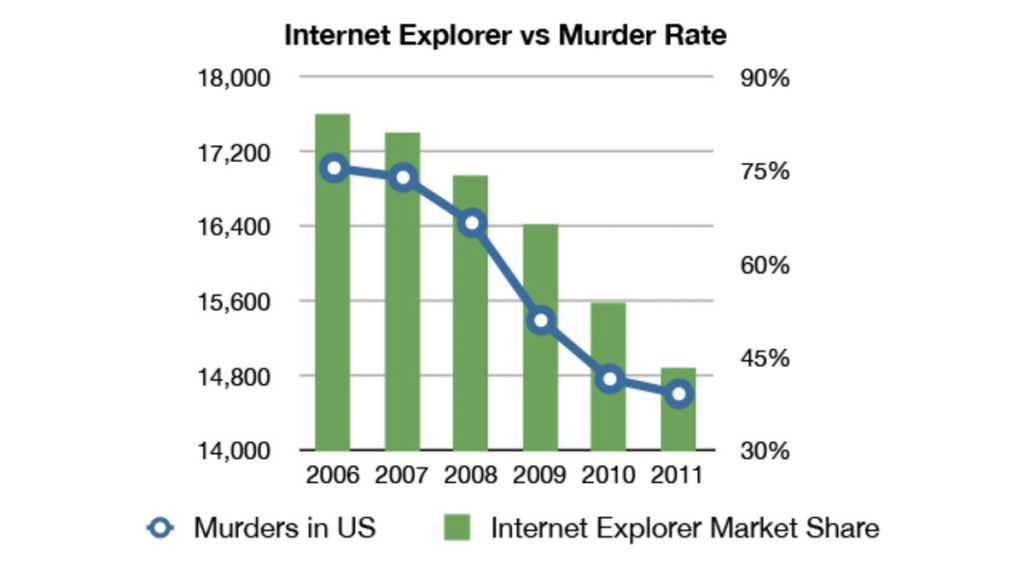

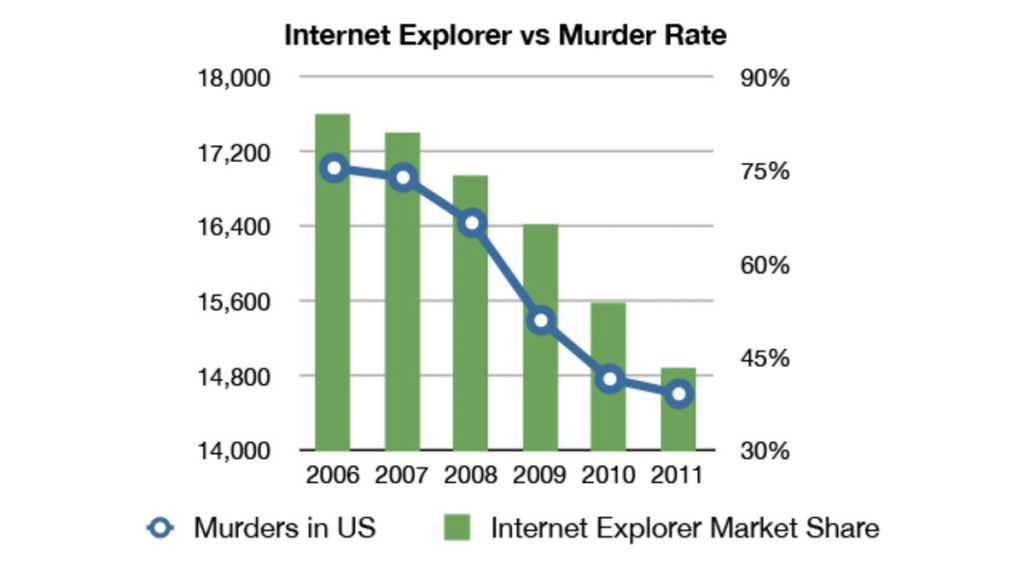

Lembro bem que ainda no início dos anos 2010 começou a circular pela internet um gráfico mostrando a direta correlação entre a diminuição da participação de mercado do Internet Explorer e a redução da taxa de homicídios nos Estados Unidos.

Será que essa é a realidade? O gráfico abaixo não mente:

Bom, o gráfico não mente, mas ele também não diz a verdade. Acontece que correlação é muito diferente de causação: não é porque um item está estatisticamente relacionado a outro que exista uma relação de causa e efeito entre eles.

De outra forma, como poderíamos explicar uma correlação quase perfeita (>95%) entre o consumo per capita de mozzarella e o número de doutorados de engenharia no mundo?

Avançando para os anos 2020, esta antiga brincadeira de encontrar correlações inusitadas evoluiu para algoritmos muito mais eficazes em encontrar verdadeiras correlações a partir de um conjunto enorme de dados, usando técnicas de aprendizado de máquina.

Por exemplo, não é surpreendente que uma plataforma de mídia social consiga determinar, com altíssimo grau de precisão, o seu gênero, profissão, faixa de idade, se você tem filhos ou não, apenas pelo seu uso da própria plataforma, sem que você tenha fornecido qualquer uma destas informações.

Ao mesmo passo que essa tecnologia é capaz de trazer muitos benefícios, ela pode ser responsável por profundas discriminações.

Se a sua empresa pretende treinar um algoritmo para selecionar candidatos usando o seu próprio banco de dados, mas historicamente a sua empresa apresenta uma disparidade homem-mulher gigantesca, o resultado esperado do algoritmo será de que: homens serão contratados com uma frequência maior do que mulheres. Esse é o caso do algoritmo da Amazon que foi completamente rejeitado após ser constatado um forte viés de gênero em suas decisões.

O caso da Amazon é um exemplo típico de profecias auto-cumpridas: se a sua empresa é discriminatória, não será a tecnologia, treinada com um banco de dados enviesado, que resolverá essa questão. Garbage in, garbage out.

O exemplo mais claro ainda é o uso de histórico criminal para predizer futuras condenações. Se esta for a principal variável analisada, é óbvio que o algoritmo retornará a predição de que criminosos no passado provavelmente cometerão mais crimes no futuro.

Mas será que esse resultado é útil? Será que ele não apresenta malefícios para uma sociedade que pretende ressocializar o indivíduo com histórico criminal positivo?

Se estas preocupações são certamente justificadas em casos tão claros de discriminação como estes, penso que elas devem ser ainda mais elevadas em situações nas quais não é tão fácil identificar um algoritmo discriminatório.

Imagine que você possui um aplicativo de internet banking instalado no seu celular. Você acessa o aplicativo do Nubank com um iPhone 4; o seu vizinho acessa o mesmo aplicativo com um iPhone 10. Você ficaria satisfeito se o Nubank concedesse um crédito maior ao seu vizinho, já que um iPhone 10 indicaria um sinal de riqueza maior do que o iPhone 4?

Se esta situação não for preocupante, imagine que este mesmo aplicativo acessa a sua geolocalização em tempo real. Pense que ele notou que você transita somente entre Itaquera e Cidade Tiradentes, ao passo que outros se deslocam diariamente entre Santa Cecília e Paraíso. Seria justa a concessão de crédito ou juros em valores diferentes para estes indivíduos?

Será que o aplicativo não está considerando que certos indivíduos são “pobres” e, por consequência, devem possuir um valor de crédito menor?

Analisaremos um último exemplo. Imagine um aplicativo de mobilidade urbana que acessa o seu endereço, geolocalização em tempo real e o seu aparelho. Se você chamar uma corrida com o seu iPhone 10, o preço será mais caro, já que você está no perfil “rico”. Se essa corrida for entre 12-13:00 na Faria Lima, você está indo almoçar ou se direcionando para uma reunião, enquadrado no perfil “rico/empresário”, “rico/advogado” ou “rico/mercado financeiro”, então o valor será maior. O aplicativo pode cobrar mais com base nesses perfis?

Mas… e se imaginarmos a situação inversa? O aplicativo sabe que o índice de crimes em determinados bairros é mais elevado e possui acesso a informações que determinada raça é mais predominante nesses bairros. O aplicativo poderia cobrar mais por corridas nestes bairros? Ou pior: o aplicativo poderia cobrar mais de pessoas pertencentes a esta raça, sob o pressuposto de que as corridas são mais “perigosas”?

Talvez o leitor já tenha percebido o que está acontecendo nestes exemplos mais sutis. No caso da Amazon, o algoritmo é treinado com informações enviesadas e retorna predições discriminatórias. Nestes casos, o algoritmo está traçando estas relações sozinho, com base em perfis criados automaticamente. Nasce aí a discriminação algorítimica por inferência.

Estas inferências não são produzidas ou controladas por humanos. Elas são o produto da análise (supostamente neutra) do algoritmo em relação a bancos de dados gigantescos.

Em termos bastante claros, não é difícil ao aplicativo vender produtos e serviços mais caros se você pertence a determinada raça, se identifica com determinada orientação sexual, mora em determinado bairro, é homem, é mulher, trans, ingressou em páginas específicas da internet (“como enganar os meus credores?”), viajou para determinados lugares, etc e etc.

Diversas considerações jurídicas resultam desta situação, que está começando a ser estudada nos principais centros de pesquisa do mundo, em particular pelo Oxford Internet Institute, sob responsabilidade da acadêmica Sandra Wachter.

Em particular, as consequências e mecanismos legais de proteção contra a discriminação algorítimica fundada em dados pessoais sensíveis (raça, religião, entre outros), sob o regime do GDPR, é objeto do meu estudo acadêmico na Universidade do Luxembourg.

O objetivo deste pequeno comentário não é elaborar em detalhes sobre elas, mas apenas apresentar o fenômeno. Contudo, vale a pena elaborarmos o porquê esta situação é preocupante do ponto de vista jurídico.

Em primeiro lugar, toda forma de discriminação deve ser repudiada juridicamente, em particular a discriminação sub-reptícia e com efeitos devastadores sobre a vida dos indivíduos. A mesma lei que protege o cidadão contra o racismo na vida real deve protegê-lo no ciberespaço.

Em segundo lugar, a opacidade típica dos algoritmos torna bastante difícil identificar estas formas de discriminação por inferência. Na prática, a melhor forma de verificar o funcionamento de um algoritmo não é ler o seu código, mas testá-lo e comparar os resultados. Nem sempre é possível conduzir testes capazes de separar variáveis como raça e orientação sexual; seria possível verificar se a Uber cobra mais de homens entre 18-25 anos? O esforço para juntar dados conclusivos a esse respeito seria monumental.

Em terceiro lugar, a LGPD brasileira regula o uso de dados pessoais sensíveis em termos mais restritivos do que o uso de dados pessoais. Por exemplo, a base de processamento “interesse legítimo” não está presente para dados pessoais sensíveis. Ademais, a LGPD demanda consentimento específico e destacado para tratamento de dados pessoais sensíveis. Estas plataformas (Brasil e afora) não possuem o consentimento específico e apartado do usuário para tratar dados sensíveis. É possível que nem mesmo as plataformas estejam cientes de que os próprios algoritmos estão utilizando dados pessoais sensíveis detectados por inferência, de tal forma que resta patente a ilegalidade destas práticas.

Poderíamos ir muito mais além sobre esse debate. No momento, o importante é levantarmos um nível de conscientização sobre estas práticas. Os mecanismos de defesa do cidadão ainda estão sendo discutidos e desenvolvidos para responsabilização de plataformas por uso de algoritmos discriminatórios.

Um abraço,

Marco.